GitHub原地址

README 就是官方的文档,不想看的可以看我的一步一步做。

环境

win 10,正因为是 windows 所以使用 ollama。

本来我是想用 vllm,但是 vllm 只能在 linux 上使用。

下载与安装软件

Ollama 在官网上点击 download 下载安装包。

下载完安装之后双击安装包,即可进行安装。

右下角会出现小羊驼的标志,说明安装成功了。

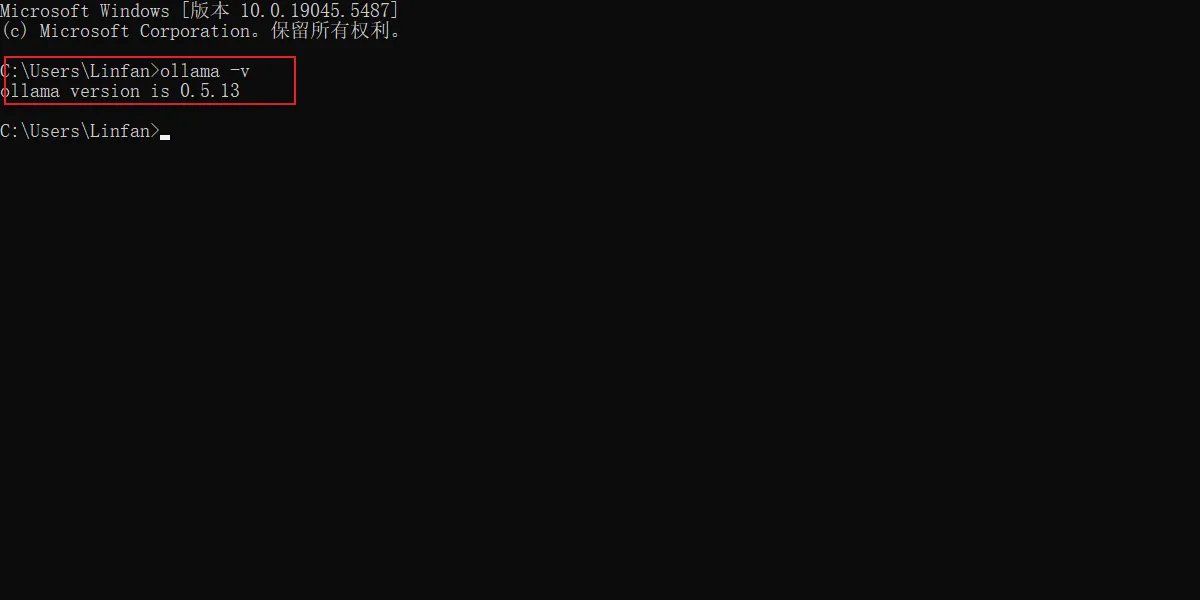

也可以 cmd。

输入 ollama -v 出现下图说明安装成功。

scoop 安装

也可以通过 scoop 进行安装,方便更新。

scoop install ollama-fullollama 在 scoop 中有两个版本,一个是位于 main bucket 中的 ollama,一个是位于 extra bucket 的 ollama-full,安装后者。

不过用 scoop 安装其实有问题,最好还是在官网安装,别用 scoop 进行安装。

安装模型

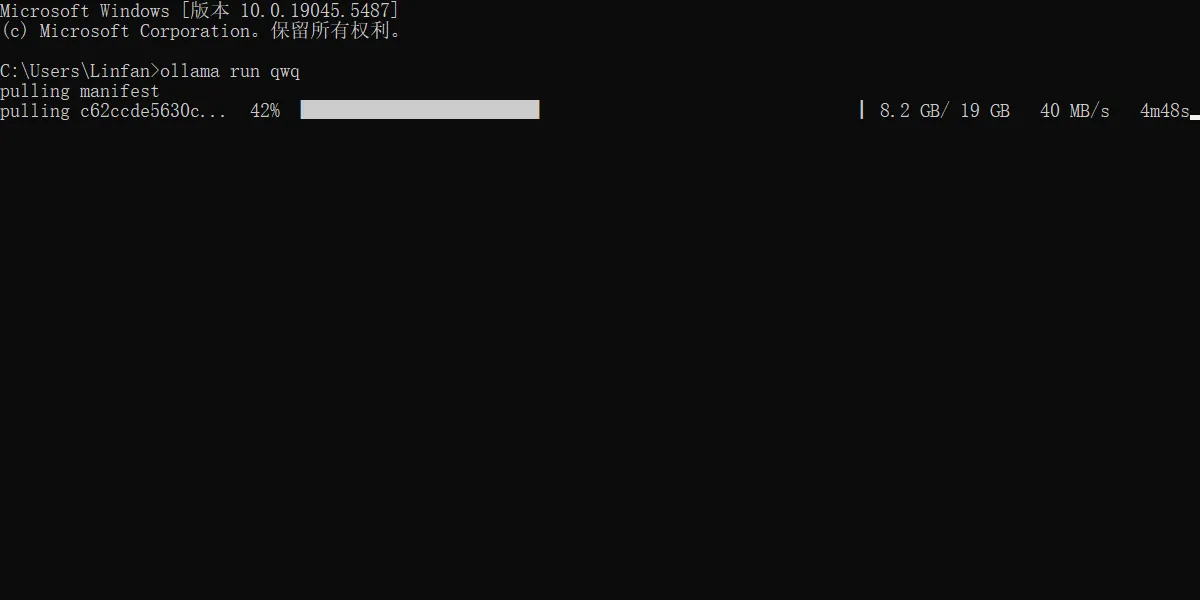

在 cmd 中输入:

ollama run xxx # xxx是模型名

# 例如

ollama run qwq即可开始下载相对应的模型。

library 这个网址是 ollama 的模型仓库,可以看看有哪些模型可以使用。

切换模型安装位置

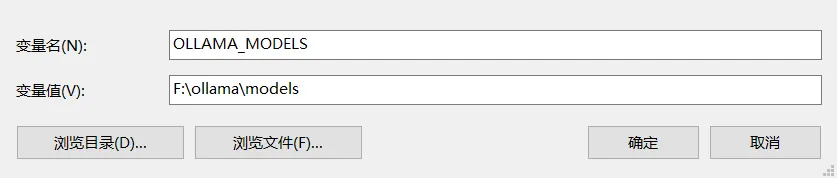

ollama 模型默认安装在 c 盘,位置如下如:

在 C:\Users\你自己的用户名\.ollama,把这个文件夹复制到你想要的位置。

打开电脑的高级系统设置,添加下面的系统变量。

然后关闭 ollama,重启 ollama 和 cmd。

输入:

ollama list能看到模型就迁移成功了。

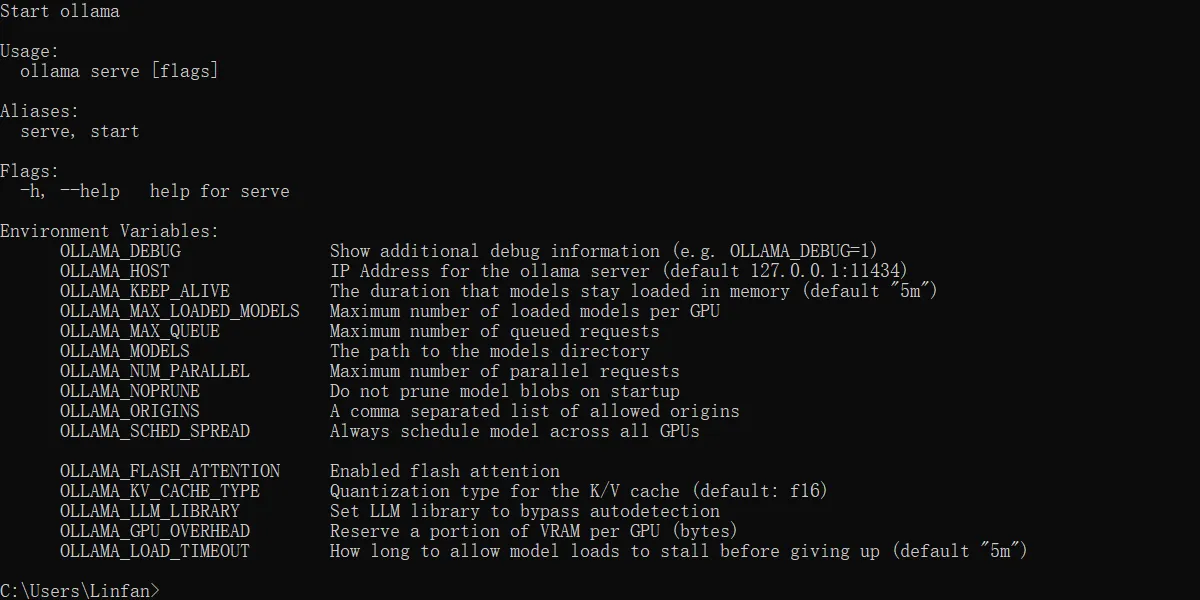

一些可以设置的系统变量

使用

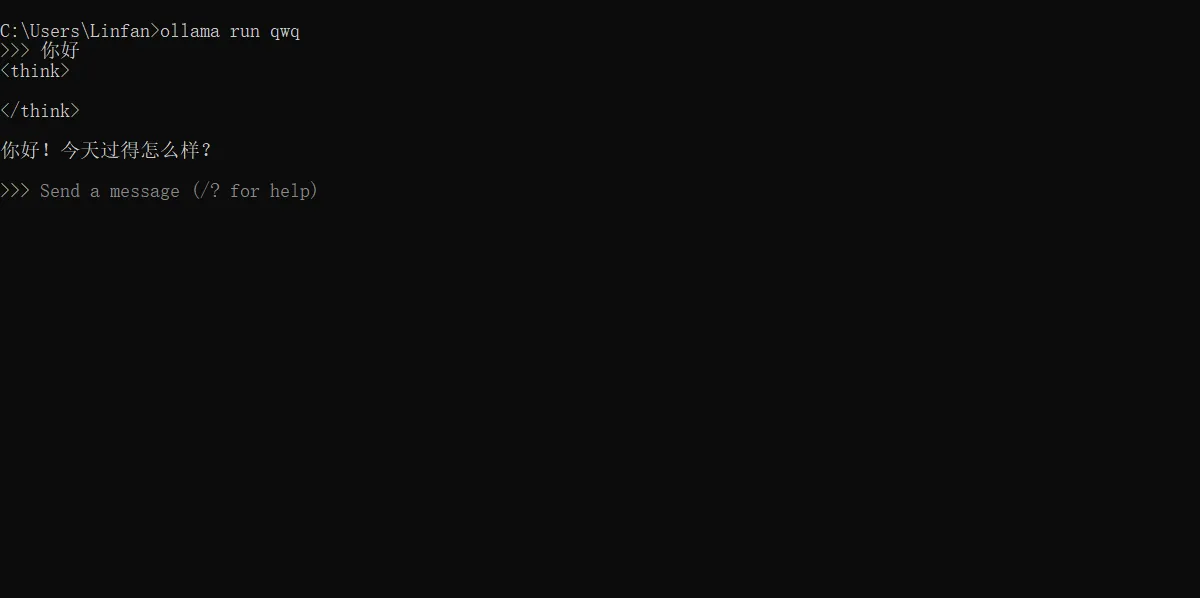

CLI

也就是终端模式,还是 ollama run 已经安装的模型名,就可以直接对话了,只是没那么好看。

Ctrl + d 可以退出。

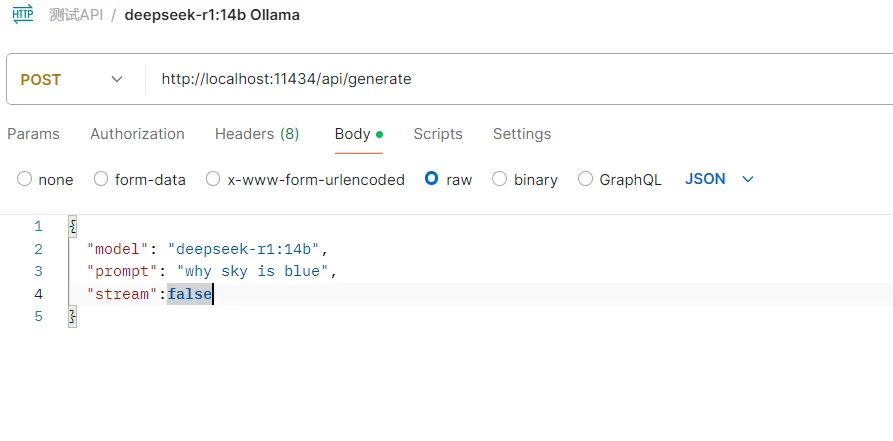

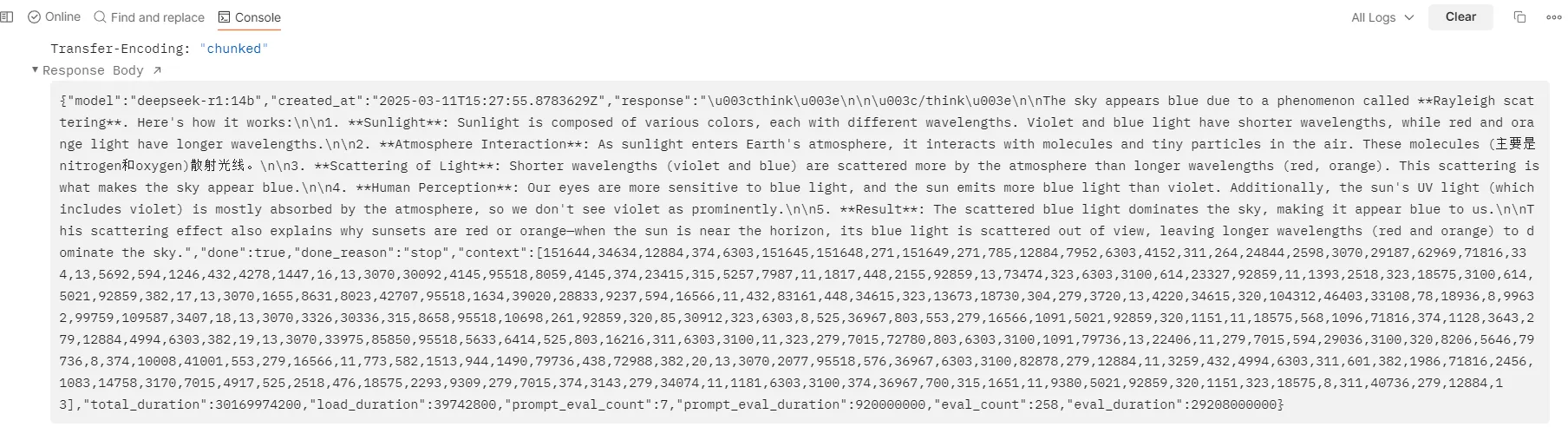

API 形式

这里使用 postman 进行测试。

使用 qwq 爆内存了,恢复速度太慢了。所以模型就换成 14 b 的 deepseek 来测试。

可以看到 OK 的 response。

能够看到 response body 中的回复。

GUI

可以安装下面的软件。

open-webui/open-webui: User-friendly AI Interface (Supports Ollama, OpenAI API, …)

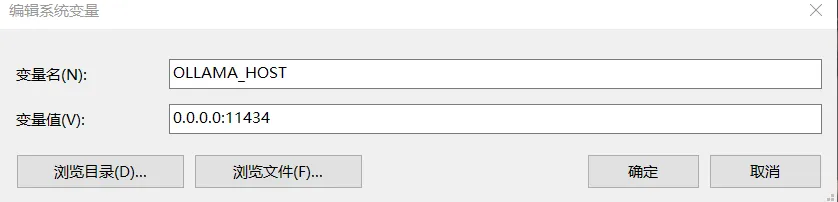

让局域网也可以访问

加入系统变量

在系统变量里面加上下面的变量:

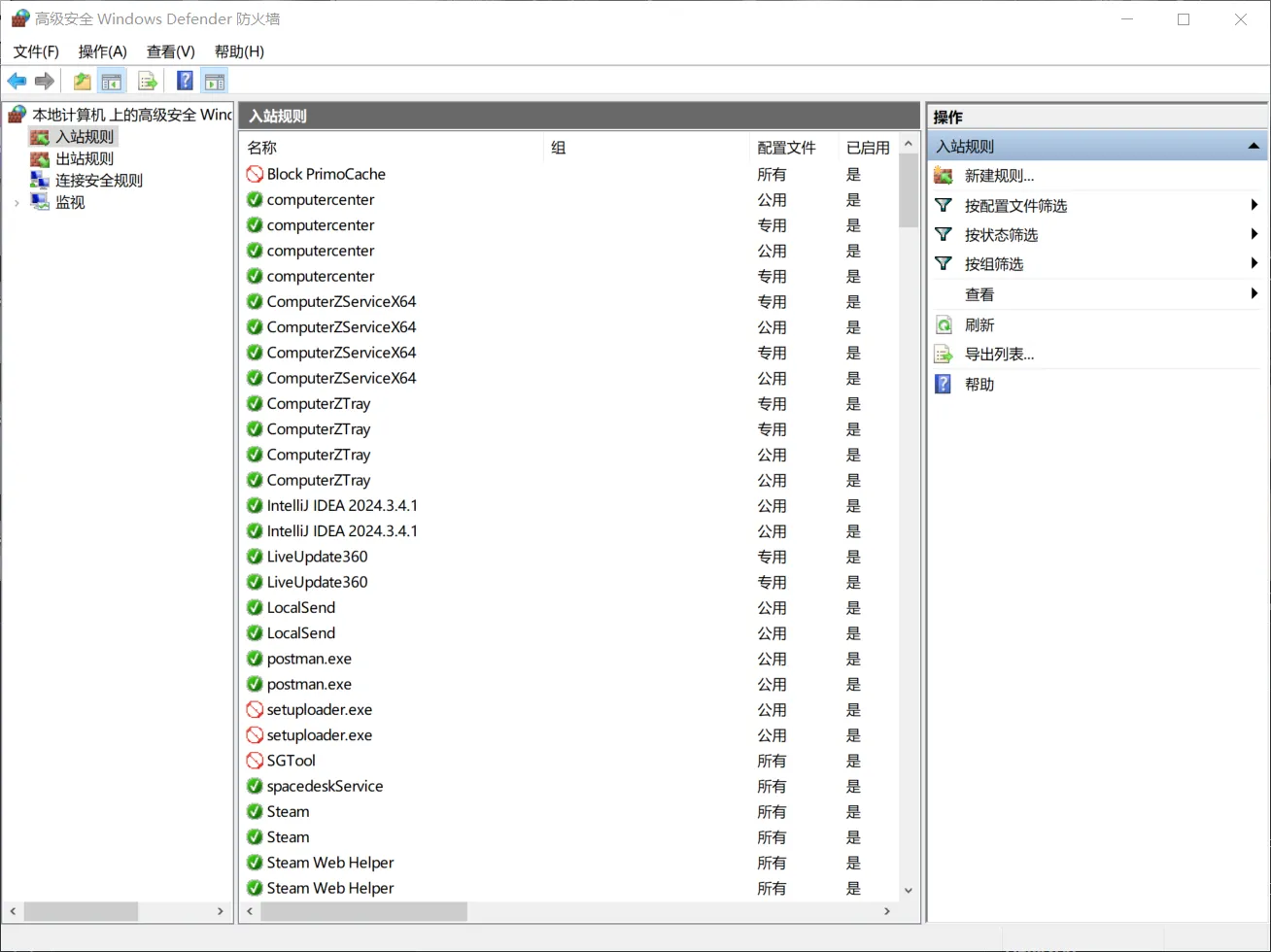

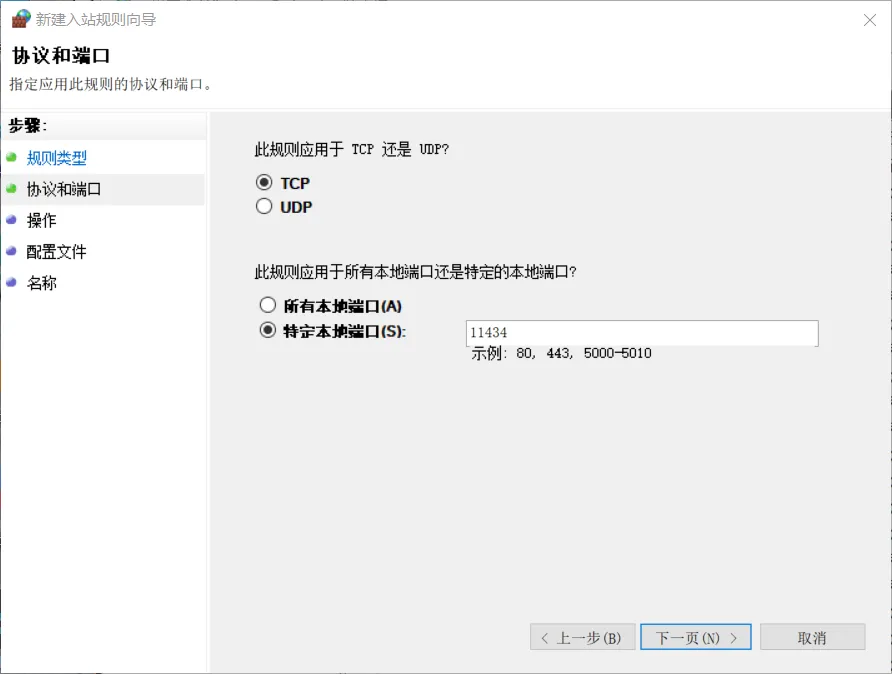

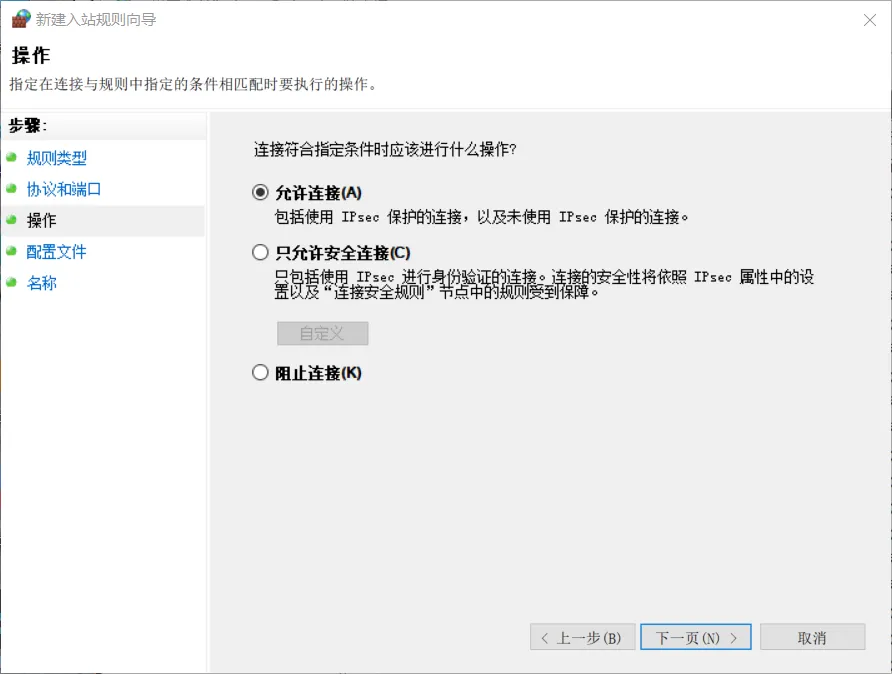

防火墙开放相应端口

接着开放相关的端口。

这里需要进入 win 10 的防火墙与网络保护,高级设置里面。

点击右侧的新建规则。

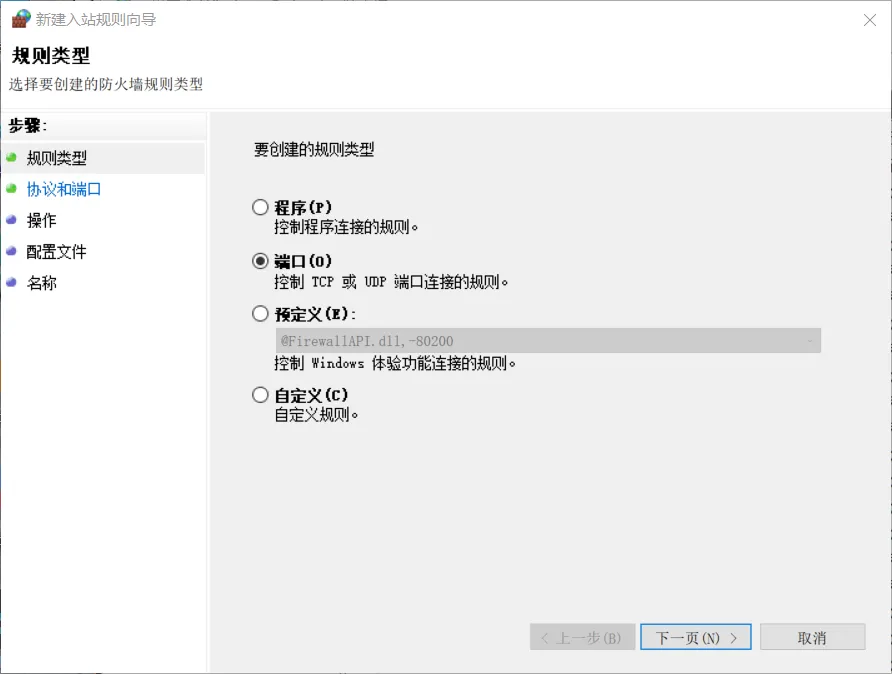

规则类型选择端口。

选择 TCP,特定本地端口为 Ollama 占用的 11434 端口。

下面就一路下一页即可,名称上面起个能之后认出来是干什么的名字。

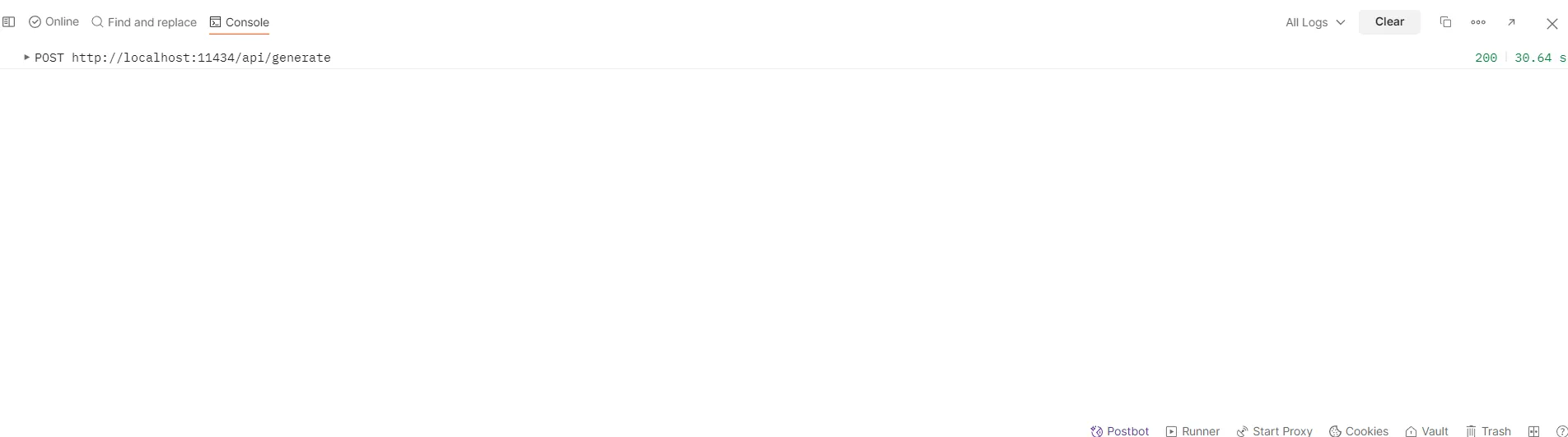

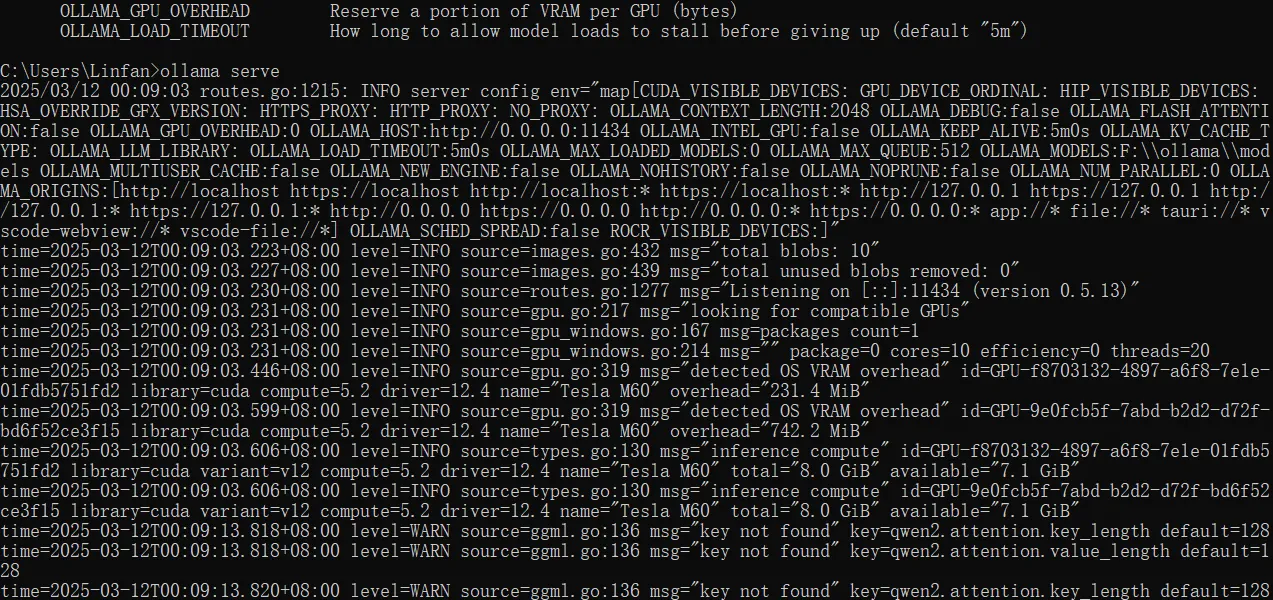

测试

首先先关闭 Ollama,也就是关闭下面的小羊驼标志。

接着 cmd 输入指令:

ollama serve

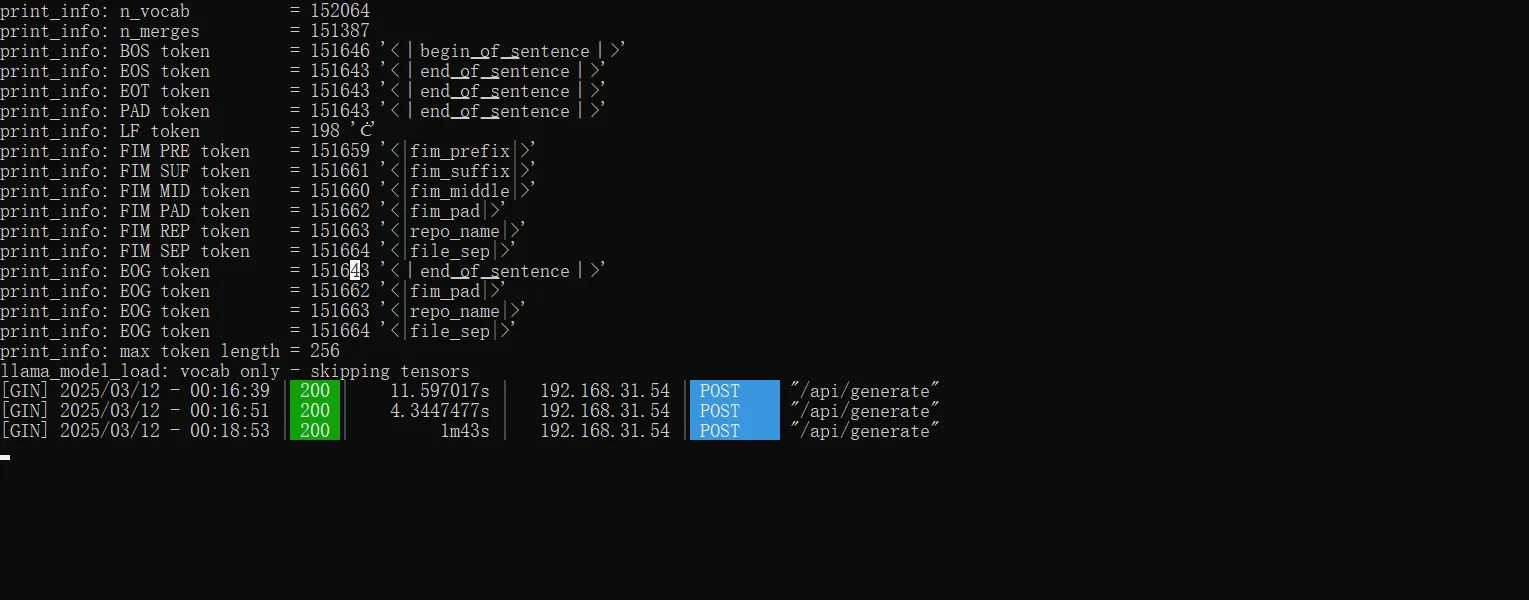

换一台电脑,在 postman 里面把原本的 localhost 改为开启了 ollama 的 ip 地址。

点击发送。

可以看到主机已经接受。